‘AI의 두뇌 크기’ 파라미터, 중국은 조 단위로 간다

생성형 AI에서 파라미터는 모델이 학습 과정에서 축적한 판단 기준의 집합이다. AI가 문맥을 이해하고 다음 행동을 결정할 때 사용하는 기준이 숫자 형태로 저장된다. 파라미터 수가 많다는 것은 그만큼 복잡한 판단을 수행할 수 있는 기반이 넓다는 의미다.

대형 언어모델 이전의 AI가 단순 패턴 인식에 머물렀다면, 수천억~조 단위 파라미터 모델은 긴 문맥 이해와 복합 추론이 가능해졌다. 중국은 이 영역에서 이미 글로벌 최상위권으로 올라섰다는 평가를 받는다.

다만 최근 경쟁의 초점은 ‘얼마나 크냐’에서 ‘어떻게 쓰느냐’로 이동하고 있다. 파라미터는 기억의 양에 가깝고, 실제 성능은 구조 설계와 활용 방식에 따라 크게 달라진다. 알리바바는 여기에 효율 전략을 결합했다.

자동 도구 선택·경험 누적 추론…중국식 고도화 전략

Qwen3-Max-Thinking의 핵심은 적응형 도구 활용이다. 모델이 대화 맥락에 따라 검색, 메모리, 코드 인터프리터를 스스로 선택해 호출한다. 사용자가 도구를 지정하지 않아도 필요한 정보 탐색과 계산 기반 추론을 수행할 수 있다.

알리바바는 여기에 경험 누적형 다회차 테스트 단계 확장 기법을 결합했다. 이전 상호작용에서 얻은 핵심 정보를 정제해 재활용함으로써, 이미 도출된 결론을 반복하지 않고 남은 불확실성 해결에 집중하는 구조다. 같은 비용 조건에서 추론 효율을 극대화하는 접근이다.

[이데일리 김정훈 기자]

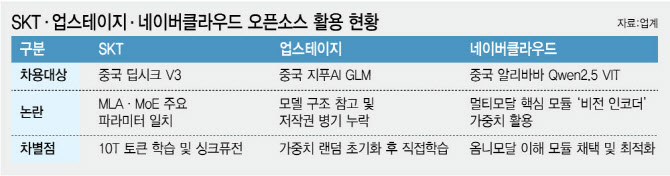

이 같은 중국 AI의 경쟁력은 한국 AI 산업의 선택에서도 드러난다. 국내 주요 AI 기업들은 이미 중국 오픈소스 모델을 기반 기술로 차용한 뒤, 자체 차별화 전략을 더하는 방식으로 경쟁력을 키우고 있다.

SK텔레콤은 중국 딥시크 V3 모델을 기반으로 IoT 토큰 학습과 성능 최적화를 강화했다.

업스테이지는 중국 지푸AI의 GLM 모델을 차용한 뒤, 기초 모델 단계에서 초기화해 직접 학습하며 성능을 끌어올렸다.

네이버클라우드 역시 알리바바의 Qwen2.5 VIT를 활용해 옴니모달 이해 모듈을 채택하고 구조 최적화에 집중하고 있다.

이는 중국 AI 모델이 더 이상 ‘참고 대상’이 아니라, 실제 산업 현장에서 쓰이는 ‘기반 기술 인프라’로 자리 잡았음을 보여준다.

빅테크는 조 단위, 한국은 효율로 대응

글로벌 빅테크 역시 조 단위 파라미터 경쟁에 뛰어들었지만, 중국의 강점은 개방성과 속도, 그리고 실사용 중심의 구조 설계에 있다는 평가가 나온다. 한국 역시 이 흐름 속에서 모델 총량보다는 효율과 적용력을 앞세운 전략을 택하고 있다.

정부가 추진 중인 ‘독자 AI 파운데이션 모델’ 1차 평가를 통과한 기업 가운데서도 모델 규모 면에서는 SK텔레콤이 가장 앞서 있다. SK텔레콤의 ‘A.X K1’은 5190억 개 파라미터를 갖춘 국내 최대 규모 모델로, 전문가 혼합 구조를 통해 추론 시 일부 파라미터만 활성화하는 방식으로 효율을 높였다. SK텔레콤(017670) ‘A.X K1’은 파라미터 수가 5,190억 개, LG AI연구원 ‘K-엑사원’은 236억 개, 업스테이지 ‘솔라 오픈’은 100억 개다.

‘크기 경쟁’ 넘어 ‘활용 경쟁’으로

한때 파라미터 수는 AI 기술력을 상징하는 지표였다. 그러나 최근 추론 AI 경쟁은 구조 설계, 학습 방식, 테스트 단계 최적화로 빠르게 이동하고 있다. 알리바바의 Qwen3-Max-Thinking은 중국 AI가 이 전환의 선두에 서 있음을 보여주는 사례다.

중국 AI는 이제 추격자가 아니라, 글로벌 AI 경쟁의 방향을 제시하는 존재로 부상하고 있다.